Pepper, nora begira gaude?

Robotak, robotak eta robotak baino ez ditugu izango etorkizun laburrean, hori ari zaizkigu esaten komunikabide anitzen teknologia atalak. Eta ez edonolako robotak, robot sozialak, robot lagunak badatoz gurekin gure etxeko egunerokotasuna konpartitzera. Errealitatea ala fikzioa, horrelako robotak gure erara portatzea da ikerlari eta garatzaileen erronka. Bada, ordea, ebatzi beharreko koska handi bat: ikusmen-arreta partekatua.

Begiradaren bitartez intereseko fokua zein dugun adierazteko gaitasuna daukagu gizakiok, begirada komunikazio iturri oso aberatsa da guretzat. Modu desberdinetan ematen da. Elkarrizketan gabiltzanean esaterako. Begiradaren bitartez informazio asko partekatzen dugu, binaka ari edo taldean ari. Eta ez dugu guztiok berdin jokatzen. Nortasunak, izaerak, testuinguruak eta jatorri kulturak eragin dezakete bestearen begietara begiratzen dugunean, edota begiradaren maiztasun eta iraupenean.

Bestetik, inguruan dagoen objekturen batean arreta partekatzea ohikoa da ahozko komunikazioari laguntzeko. Adibidez, ibilgailu gorriari begirada luzatzea “hori da nire autoa” esaten dugunean. Beste batzuetan arreta partekatzen dugu horren konstantziaren beharrik gabe. Adibidez, etxekoekin telebistari begira gaudenean pantaila da guztien arreta fokua, baina informazio hori ez dugu esplizituki konpartitzen.

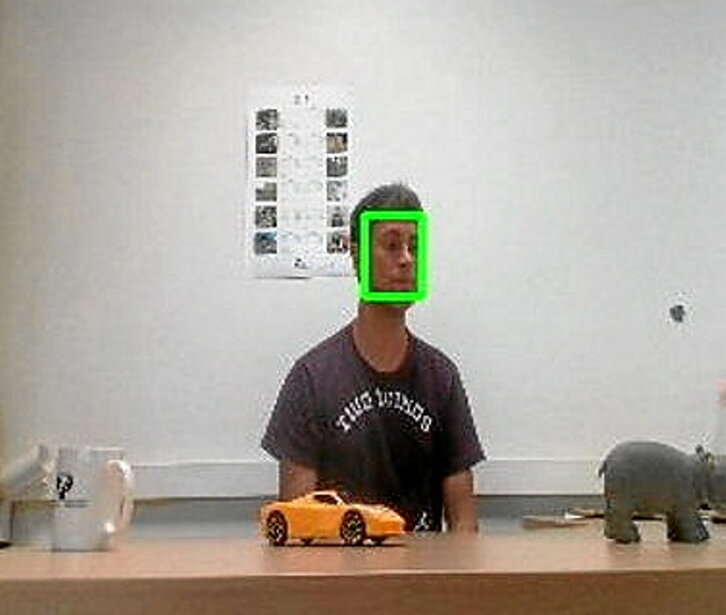

Baina, nola gauzatu hori robotekin, nola lortu robotek nora begira ari garen jakitea eta horren esanahia ulertzea? Guretzat automatikoa dena, robotak sintetikoki erreproduzitu beharko du nola edo hala. Kamera beharko du, ikusmira egokia lortzeko. Bideo zein irudi horiek prozesatu beharko dira. Fase desberdinak eskatzen ditu prozesu honek, guztietan lehena irudian inor dagoen erabakitzea. Baiezkoan:

Begiradaren noranzkoa atzeman behar da. Bi modutara egin daiteke hau: irudian aurpegia kokatu, begiak eta niniak lokalizatu eta bi horien angeluak aztertu. Errealitate birtualerako gailuetan erabiltzen da era hau, ez, ordea, robot sozialetan. Bigarrena, buruaren eta aurpegiaren marketatik (begiak, sudurra eta ahoa) abiatuz, begirada-bektorea lortzea datuetatik ikasiz, adibidez, sare sakonak erabiliz. Estimazioa baino ez dugu lortzen, zehaztasuna txikiagoa da, beraz, baina orokorragoa da metodoa eta erabilerrazagoa.

Begiradaren noranzko horretan zer dagoen erabakitzea geratzen zaigu. Gaur egun badira irudi batean dauden elementuak identifika ditzaketen tresnak, adibidez YOLO, baina ez dira inola ere %100 fidagarriak. Murphy-ren esaerei jarraituta, Jarri arraina begietan eta betaurrekoak izango dira sistemaren aburuz. Masailean jarriz gero, ordea, telefonoa.

Honaino, robotak aurrean duen pertsona horren foku bisualean dagoena identifika dezake, baina arreta partekatuan “ulermena” adierazi behar du eta, horretarako, bertara begiratu beharko du une batez bada ere. Honen guztiaren naturaltasunean egongo da komunikazioaren zantzua. Mezuaren hartzaileak ulertu al du hitzik gabeko mezua, robotak interpretatu al du berea? Ez da arazo makala, baina interes handiko ikerkuntza lerroa da, eta aplikazioak ere ugariak. Imajinatzen al duzu zure burua “ikusi makusi”-ra jolasten Pepper robotarekin? Ikusi ondorengo bideoa. •

Siriaren txingarra itzali ala gasolinaz sutuko da?

Livoniera, joan-etorriko hizkuntza bat Baltikoan

Olentzero eta Mari Domingiri gutuna idazteko kontuan hartu beharrekoak